LLM : forces inductives, faiblesses déductives

L'importance de la distinction entre raisonnement inductif et déductif dans les LLM

Les grands modèles de langage (LLM) tels que GPT-3 et GPT-4, capables de générer du texte cohérent, de répondre à des questions complexes et même de résoudre des problèmes sophistiqués, suscitent autant d'admiration que d'interrogations.

Une de ces interrogations se trouve être une question fondamentale : est-ce que ces modèles raisonnent ? Et si oui, comment ces systèmes raisonnent-ils réellement ?

C'est à cette question que s'attaque des chercheurs de l’Université de Californie et d’Amazon à l’origine de la publication de l'article "Inductive or Deductive? Rethinking the Fundamental Reasoning Abilities of LLMs".

Cette étude propose une approche méthodologique visant à dissocier et à évaluer deux formes fondamentales de raisonnement chez les LLM : l'inductif et le déductif. Alors que les recherches précédentes ont souvent confondu ces deux modes de pensée, cette recherche propose une compréhension plus nuancée et précise des capacités cognitives de ces systèmes.

Temps de lecture de l’article complet 5 mins / Temps de lecture du résumé : 1 min

En résumé :

1. L'étude cherche à comprendre comment les grands modèles de langage (LLM) raisonnent, en se concentrant sur la distinction entre raisonnement inductif et déductif.

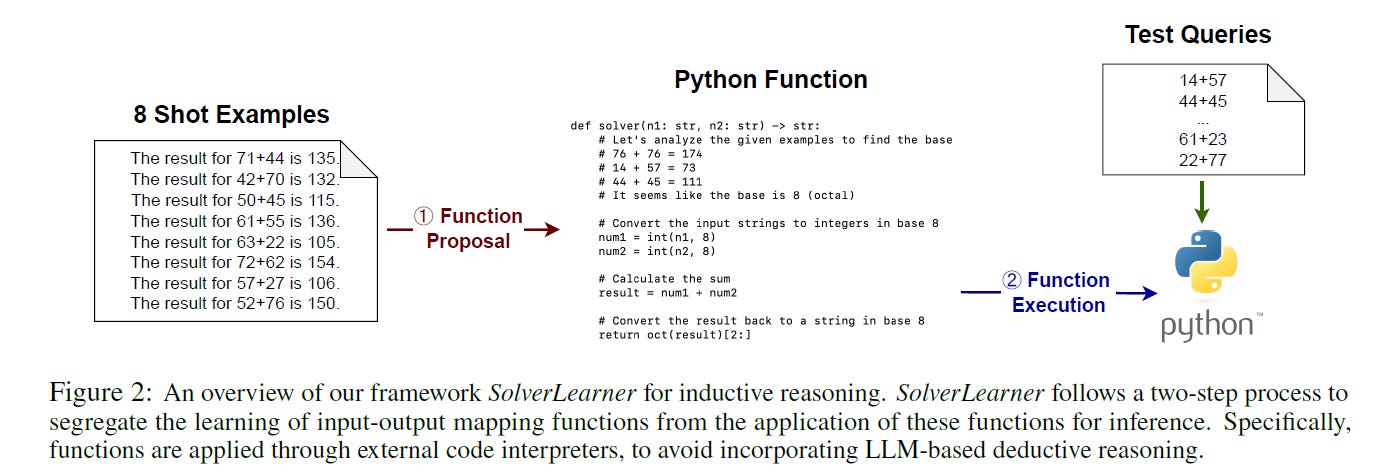

2. Les chercheurs ont développé un nouvel outil appelé SolverLearner pour isoler et évaluer spécifiquement les capacités de raisonnement inductif des LLM, en séparant le processus en deux étapes : l'apprentissage à partir d'exemples et le test de la règle déduite.

3. L'étude révèle que les LLM excellent en raisonnement inductif (apprentissage à partir d'exemples) mais ont des difficultés avec le raisonnement déductif, surtout dans des situations nouvelles ou inhabituelles. Les performances varient selon le modèle, GPT-4 surpassant généralement GPT-3.5.

4. Ces résultats pourraient guider le développement futur des LLM et leur application dans divers domaines. Cependant, l'étude a des limites, notamment concernant la complexité des tâches et la généralisation des résultats à d'autres types de problèmes.

Déductif vs inductif

Pour tenter d’évaluer la portée de cette étude, il est important de comprendre la distinction entre le raisonnement déductif et inductif. Le raisonnement déductif est un processus logique qui part de prémisses générales pour arriver à une conclusion spécifique. Si les prémisses sont vraies, la conclusion doit nécessairement être vraie. Par exemple, si nous savons que tous les hommes sont mortels et que Socrate est un homme, nous pouvons en déduire que Socrate est mortel. Dans le contexte des LLM, une tâche de raisonnement déductif pourrait consister à fournir une règle générale et à demander au modèle d'appliquer cette règle à un cas spécifique.

Le raisonnement inductif, en revanche, part d'observations spécifiques pour tirer des conclusions générales. Ces conclusions sont probables, mais pas nécessairement certaines. Par exemple, si nous observons 100 cygnes et qu'ils sont tous blancs, nous pourrions en conclure que tous les cygnes sont probablement blancs. Pour les LLM, une tâche de raisonnement inductif pourrait consister à fournir plusieurs exemples d'une règle sans expliciter la règle, et demander au modèle de déduire la règle générale.

SolverLearner

Pour mieux comprendre ces deux types de raisonnement chez les LLM, les chercheurs ont mis au point une nouvelle méthode appelée SolverLearner. Ce framework est spécialement conçu pour examiner comment les LLM apprennent à partir d'exemples, ce qui correspond au raisonnement inductif.

SolverLearner fonctionne en deux étapes. D'abord, on montre au LLM plusieurs exemples de problèmes résolus et on lui demande de deviner la règle générale qui permet de les résoudre. Ensuite, on utilise un programme séparé pour tester si la règle proposée par le LLM fonctionne sur de nouveaux problèmes. Cette approche permet d'isoler et d'étudier spécifiquement la capacité de raisonnement inductif des LLM, contrairement aux méthodes précédentes qui mélangeaient souvent différents types de raisonnement.

Les résultats de cette étude suggèrent que les LLM offrent de meilleures performances dans l'apprentissage de modèles à partir d'exemples (induction), mais ont des difficultés à appliquer des règles explicites dans des contextes nouveaux ou inhabituels (déduction).

Les résultats obtenus grâce à cette nouvelle méthode sont très révélateurs. Ils montrent que les LLM sont particulièrement doués pour le raisonnement inductif, c'est-à-dire pour apprendre à partir d'exemples et en tirer des règles générales. En revanche, ces modèles ont plus de difficultés avec le raisonnement déductif, surtout dans des situations inhabituelles ou nouvelles pour eux. L'étude a également révélé que les performances varient considérablement selon le modèle de base utilisé, GPT-4 surpassant généralement GPT-3.5.

Des implications multiples

Cette nouvelle compréhension pourrait guider le développement de futures architectures de LLM, en se concentrant sur l'amélioration des capacités de raisonnement déductif tout en capitalisant sur les forces du raisonnement inductif. Les forces des LLM en raisonnement inductif pourraient être exploitées dans des domaines tels que l'analyse de données, la reconnaissance de modèles, ou l'apprentissage automatique non supervisé. Mais il n’en reste pas moins que la compréhension des limites des LLM en matière de raisonnement déductif soulève des questions importantes sur leur utilisation dans des domaines nécessitant un raisonnement logique strict, comme la prise de décision médicale ou juridique.

Cette recherche qui apporte un éclairage nouveau, a aussi ses limites. Les chercheurs ont remarqué que les LLM ont plus de mal à apprendre à partir d'exemples quand les problèmes deviennent très complexes ou quand il y a trop de solutions possibles. De plus, on ne sait pas encore si ces résultats s'appliquent à tous les types de problèmes ou seulement à ceux étudiés dans cette recherche.

D’un point de vue plus global, cette étude s'inscrit dans un courant de recherche visant à comprendre les capacités cognitives des LLM. Et contrairement à de nombreuses études antérieures qui se concentraient sur des tâches spécifiques, cette recherche offre une perspective plus fondamentale sur les mécanismes de raisonnement sous-jacents. La distinction claire entre raisonnement inductif et déductif proposée ici contraste avec des approches précédentes qui tendaient à évaluer ces capacités de manière plus globale.

Pour lire l’article complet : Inductive or Deductive? Rethinking the Fundamental Reasoning Abilities of LLMs - https://doi.org/10.48550/arXiv.2408.00114

N’hésitez à me contacter si vous avez des remarques et suggestions sur cette newsletter, ou si dans votre entreprise vous cherchez à être accompagnés dans l’intégration d’outils d’IA générative : olivier@255hex.ai

Et n’oubliez pas de vous abonner pour recevoir IA-Pulse