Forum des Éclaireurs du Droit : "Est-il raisonnable de faire confiance aux contenus créés par l’IA ?"

Sagesse, audace, tempérance, tels étaient les thèmes évoqués lors de cette journée.

Temps de lecture de l’article complet 7 mins

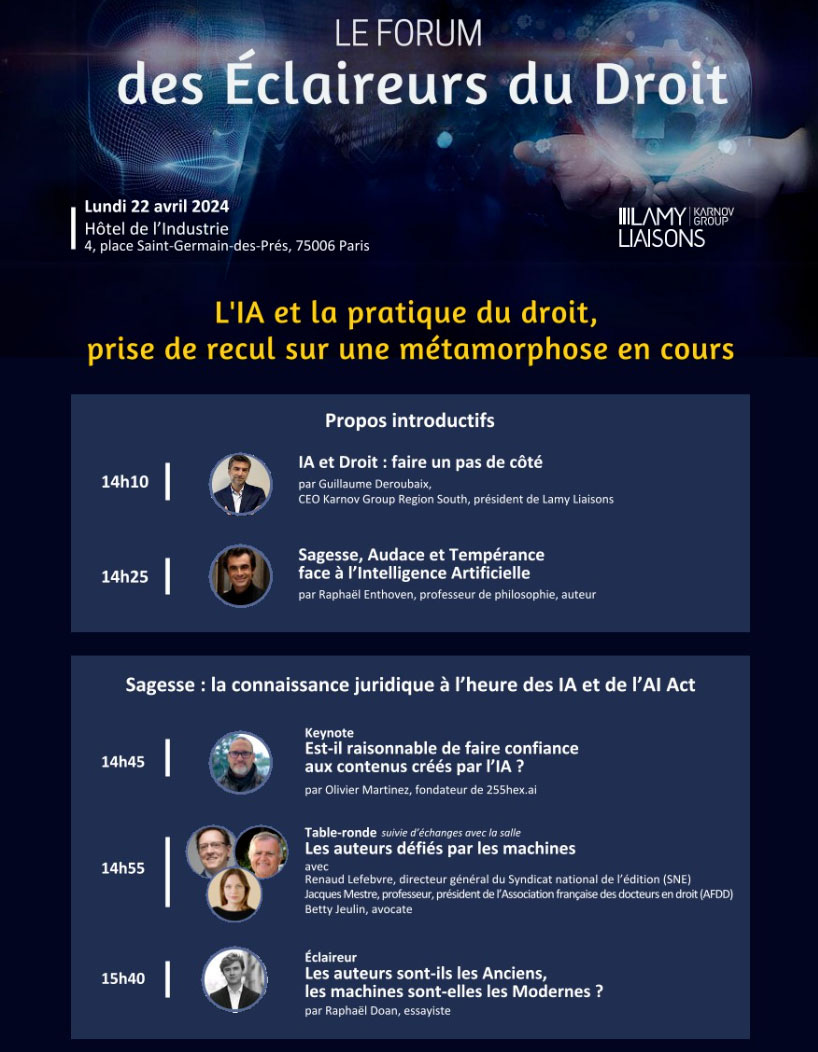

Le contenu du texte ci-dessous a été prononcé (beaucoup moins bien qu’il n’avait été pensé et écrit) lors d’une intervention au Forum des Eclaireurs du Droit organisé par Lamy Liaisons le lundi 22 avril 2024 à Paris.

Est-il raisonnable de faire confiance aux contenus crées par l’IA ?

Bonjour à toutes et à tous.

Je ne suis pas scientifique, chercheur, ou ingénieur. Pas non plus psychologue, sociologue, linguiste ou philosophe, et absolument pas avocat ou juriste.

Je suis un product manager, et mon travail est de définir, en général avec d’autres humains, des produits numériques. Je m’intéresse alors à la création de valeur, pas n’importe laquelle, principalement la valeur usage. C’est par cet angle que nous allons évoquer ensemble l’IA générative.

Pour lever les ambiguïtés sur le terme IA lui-même, ici nous allons parler d’un type particulier d’IA : l’IA générative - qui est devenue quasiment synonyme du domaine entier de l’IA alors qu’il n’en est rien. Et plus particulièrement nous allons parler des grands modèles de langage, LLM en anglais, qui sont à la fois des éléments de l’IA générative, ils génèrent du texte, mais qui sont aussi bien souvent utilisés comme porte d'entrée pour d’autres outils d’IA générative. Par exemple, ces LLM nous permettent de donner des ordres en langage naturel à d’autres modèles qui vont produire des images.

Qu’est-ce que l’IA générative ? Très grossièrement se sont des réseaux neuronaux à qui dans un premier temps l’on donne à manger des corpus géants de données, ici des textes, et qui établissent des relations statistiques entre tous les éléments qu’ils mangent. Ils sont ensuite capable de restituer, de générer - d’où leur nom, des éléments similaires à leur corpus d’entraînement. Ils ne font pas de copier-coller. Ils produisent des textes réalistes, corrects d’un point de vue de la syntaxe et de la grammaire et en théorie originaux.

Dis comme ça, ça n’a pas l’air si compliqué et leur usage potentiel est simple. Mais ces modèles ont des gros défauts. Ils sont si nombreux, que nous n’allons pas avoir le temps de tous les évoquer. Je vais m’attarder sur quelques points qui sont liés à la valeur d’usage que nous y mettons.

Nombre d’entre nous, les humains, nous avons une fâcheuse tendance à détourner les usages des outils. Nous utilisons ces modèles comme un moteur de recherche. Et nous en attendons le même degré de précision qu’un moteur de recherche. Il faut dire que nous sommes bien aidé dans cette démarche par tout le marketing et la communication faite autour des LLM par les grands acteurs du marché. Mais ce ne sont pas des moteurs de recherches. Ce ne sont pas non plus des bases de données ou des bases de connaissances au sens premier. Ce sont des modèles statistiques, que souvent nous réduisons par commodités, et moi le premier, à des modèles qui calculent uniquement des probabilités que des mots suivent d’autres mots, bien qu’ils sont peut-être un peu plus que ça.

Second problème. Ils hallucinent : c’est inhérent à la leur condition. C’est “by design”. Ils produisent du contenu qui n’a aucune référence dans le monde réel et qui pourtant à l’apparence du vrai. Tous les LLM hallucinent, quel que soit le sujet. C’est inévitable. C’est naturel pour eux. Les meilleurs d’entre eux qui sont accessibles au grand public, ont des taux d’hallucination autour des 25%. Mais vous savez quoi, ils sont quand même très persuasifs. Une étude récente montre qu’ils arrivent à être plus persuasifs que des humains dans leur utilisation de la langue, aussi bien d’un point de vue syntaxique que grammatical. Ils manient peut-être mieux le langage naturel que la majorité d’entre nous. Tout en nous disant des contre-vérités.

Troisième gros souci, c’est le manque d’explicabilité. Vous avez certainement entendu parler de ces LLM qui réussissent à répondre correctement à des QCM pour passer le concours du barreau de tel ou tel État aux États-Unis, ou encore de modèles qui obtiennent de très bons scores à des QCM proposés normalement à de futurs docteurs en médecine. Certes c’est époustouflant. Mais ils sont incapables d’expliquer pourquoi ils ont répondu telle chose ou telle autre. Impossible aussi pour eux d’indiquer leurs sources. Il faut partir du principe que, de par leur nature, les outils mis à notre disposition actuellement n’ont aucune notion de sens, de valeurs, ou de culture derrière les mots qu'ils génèrent. Le sens d’une phrase générée par un algorithme est uniquement apporté par l’humain qui la prononce ou la lit.

Il y a enfin un 4ème point dont je voulais vous parler. Et c’est nous les humains qui sommes encore en cause. Ces modèles répondent à des stimulus, à des demandes que nous leur formulons. A partir de la commande initiale, du prompt, la machine va “calculer” la meilleure réponse. De la façon de formuler ce prompt va en découler une réponse, qui pourrait peut-être changée si une virgule n’était pas à la même place. Nous ne nous en rendons pas réellement compte mais nous guidons la machine. Gardons à l’esprit qu’avec les technologies actuelles, la réponse est le miroir du prompt.

Au moment où je vous parle, ces modèles de langage, ces IA génératives, ne sont pas des outils qui font des choix par eux-mêmes, ils ne sont pas animés de convictions, le raisonnement hypothético-déductif et le concept de causalité leur sont encore assez étrangers. Ils ne font pas non plus de planification, et par-dessus tout, ces modèles ne savent pas rendre compte des contraintes de la réalité physique.

Et puis nous pourrions comme ça continuer de parler de beaucoup d’autres problèmes comme l’opacité des corpus d’entrainement, les biais, etc.

Donc comment avoir confiance en ces modèles ? Comme je ne fais pas de prospective, de prédictions et encore moins de science-fiction, je serais enclin à vous dire qu’il faut les utiliser pour ce qu'ils sont actuellement et les laisser pour ce qu’ils ne sont pas, ou les laisser à ce que certains vous promettent qu’ils seront demain.

En tout premier, ce sont de formidables travailleurs du texte. Ils sont capables de résumer, découper, allonger, changer de style, regrouper, comparer, traduire…

Puis, pour réduire les réponses hors-sol, nous avons des techniques et technologies que certains ici doivent déjà expérimenter ou utiliser, comme le Finetuning, le RAG ou le réentrainement par exemple, qui permettent d’apporter des données ou des connaissances vérifiées à ces modèles qui eux savent manier la langue pour les mettre en forme. En gros nous pouvons les mettre sur des rails. Tout cela en gardant en tête que nous n’éliminerons pas totalement les hallucinations.

Ce que nous pouvons faire avec ces modèles, c’est utiliser notre langage naturel dans une forme conversationnelle pour discuter avec des masses de données que nous savons qualifiées et justes. En termes d’accessibilité aux données c’est un changement : l’expression de l’intention sous-jacente à nos demandes devient primordiale. Avant nos interactions étaient basées sur des commandes précises et explicites. Du langage informatique. Ce n’est plus totalement le cas.

Et de façon plus opérationnelle, nous devons faire travailler ces modèles uniquement sur des sujets que nous connaissons et maitrisons. Pour tout le reste, nous avons notre cerveau.

Pour en terminer ici, permettez-moi de faire un peu de sociologie et de psychologie de comptoir.

Quand nous abordons ces modèles faisons comme si c’était une nouvelle ou un nouveau collègue : il a un beau CV, nous connaissons son parcours antérieur, mais nous le regardons à l’œuvre, nous l’évaluons avant de lui donner notre confiance. La confiance s’établit au cours du temps. Adoptons ce type d’approche avec ces modèles.

Il faut tester ces outils avec un regard critique. Il faut se former à ses outils pour en percevoir les avantages et les limites. Et quoi qu’il en soit, et quel que soit le contenu produit par ces modèles, à la fin il y a toujours une décision humaine qui fait qu’un contenu généré est utilisé ou non. Si ce n’est pas la cas, cela devrait l’être. La responsabilité reste du côté humain.

N’hésitez à me contacter si vous avez des remarques et suggestions sur cette newsletter, ou si dans votre entreprise vous cherchez à être accompagnés dans l’intégration d’outils IA et d’IA générative : olivier@255hex.ai

Et n’oubliez pas de vous abonner pour recevoir IA-Pulse